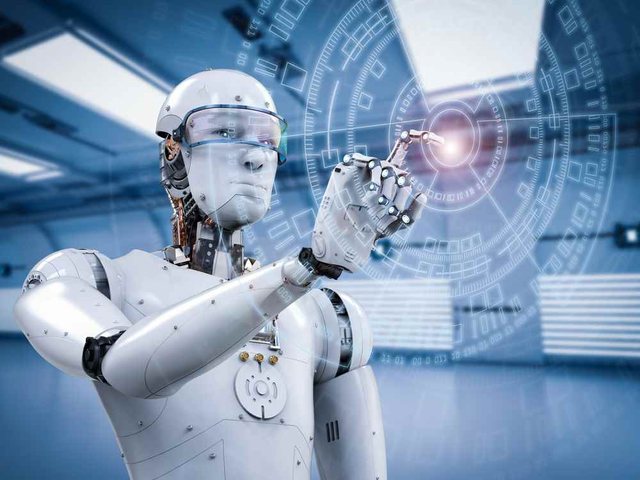

The four clans that command over Artificial Intelligence

Techno-apocalyptics, utopians, those concerned with ethics and security: the four groups dominating the debate over AI development. Whose ideas have ignited the battle for OpenAI leadership.

The saga that has had as its protagonist the company OpenAI (which created ChatGPT) in recent weeks, has brought to light a conflict that has been going on for some time, and that has involved the Artificial Intelligence sector.

In fact, at the origin of Sam Altman's firing (then reinstatement) lay major differences between OpenAI's founder and the board of directors (whose members were subsequently replaced, almost entirely) over the proper way to further develop this innovation. So opposite visions, which sometimes take on ideological nuances.

On the one hand, the previous board of directors – led by chief scientific officer Ilya Sutskever – considered artificial intelligence an inherently dangerous technology that needed to be handled with care. On the other hand, Sam Altman, convinced - as he wrote in a post a few months ago - that strong artificial intelligence (that is, able to achieve human capabilities from any perspective) "can elevate humanity".

What happened inside OpenAI follows the conflict that has been going on for some time in Silicon Valley. This clash has at its opposite poles the so-called doomers (the techno-apocalyptic, who are convinced that a strong AI poses "existential dangers" for human beings) and the techno-utopians, who are sure that this technology will lead us to a better future, and will allow human beings to reach levels of well-being never seen before.

By exploiting their economic, political or academic influence, these groups are leaving in the background those - like most computer scientists - who are trying to focus on more concrete and realistic issues.

Techno-apocalyptics

In 2014, Elon Musk declared that the development of Artificial Intelligence was the technological equivalent of "summoning the Devil". At the time, generative AI (capable of producing text itself like ChatGPT, images like Midjourney or even sounds and videos), was still a long way off. The most widespread applications of "deep learning" were related to image recognition or personalized suggestions. However, Musk, certainly influenced by the writings of the controversial philosopher Nick Bostrom (author of the essay Super-intelligence), warned at that time against what he considered to be the great dangers of this technology.

Që nga ajo kohë, Musk është bërë një lider i tekno-apokaliptikëve dhe i teorisë së “rrezikut ekzistencial”, sipas së cilës zhvillimi i Inteligjencës Artificiale, do të çojë në mënyrë të pashmangshme në një super-inteligjencë, e cila nga ana tjetër mund t’i shpëtojë kontrollit të qenieve njerëzore dhe të rebelohet kundër këtyre të fundit.

Ky vizion e nxiti të themelonte OpenAI, që synonte zhvillimin e Inteligjencës Artificiale në një mënyrë “të sigurt dhe të përgjegjshme”. Me kalimin e viteve, teoria e “rrezikut ekzistencial” të paraqitur nga AI, ka fituar mbështetje gjithnjë e më të madhe në mesin e anëtarëve më radikalë të shumë grupeve të mendimit, përfshirë institutin “Future of life”, që pak muaj më parë publikoi ??një letër të hapur ku bënte thirrje për ndalimin e zhvillimit të këtyre mjeteve. Teoria e “rrezikut ekzistencial” ishte në qendër të samitit të fundit mbi AI, i organizuar nga kryeministri britanik Rishi Sunak.

AI Safety: Garantët e zhvillimit të sigurt të Inteligjencës Artificiale

Është grupi që mbi gjithë konsideratat e tjera, dëshiron që zhvillimi i Inteligjencës Artificiale të ndodhë në mënyrë të sigurt. Ai hulumton në çdo moment mbi mënyrat më premtuese, për të parandaluar që AI t’i shpëtojë kontrollit tonë dhe të rebelohet kundër qenieve njerëzore, madje edhe pa e kuptuar këtë gjë.

Imagjinoni skenarin e mëposhtëm dhe tashmë të mirënjohur (të cilin ia detyrojmë sërish Bostrom): një Inteligjencë Artificiale veçanërisht e avancuar merr komandën për të maksimizuar prodhimin e kapëseve të letrës. Duke e interpretuar fjalë për fjalë objektivin që i është dhënë, kjo AI konsumon të gjitha burimet e planetit tonë për të prodhuar sa më shumë kapëse letre, duke shkaktuar pa dashje edhe zhdukjen e qenieve njerëzore.

Siç e thekson edhe Melanie Mitchell, profesoreshë e Kompleksitetit në Universitetin e Santa Fe, “ne duam që makinat të bëjnë atë që ne synojmë ne, por jo domosdoshmërisht atë që u themi”. A është e mundur të arrihet ky objektiv, dhe të sigurohet që Inteligjenca Artificiale të jetë në gjendje të kontekstualizojë dhe balancojë komandat tona, duke i interpretuar ato ashtu si ne njerëzit?

Sipas kësaj teze, përçimi tek makinat i vlerave tona njerëzore, do t’i lejonte ato të interpretonin komandat në mënyrë korrekte, duke mos u kufizuar tek “maksimizimi i funksionit objektiv” (pra ta përfundojnë detyrën që i është dhënë, në mënyrën më efikase të mundshme), por duke e kuptuar në mënyrë të pavarur se çfarë duam ne njerëzit në të vërtetë, dhe cilat janë kufijtë dhe kufizimet që duhen respektuar (për shembull, shmangia e shkatërrimit të planetit për të prodhuar një numër të tepruar kapësesh letre).

Megjithatë, mbetet i hapur dhe shumë larg zgjidhjes problemi se si t’i transmetojmë në mënyrë efektive vlerat tona këtyre makinave. Aktualisht, janë duke u zhvilluar disa eksperimente, të cilat nuk kanë çuar ende tek rezultatet përkatëse. Ndër ndjekësit e kësaj shkolle mendimi, është edhe ish-drejtori shkencor i OpenAI Ilya Sutskever, themeluesi i DeepMind, Demis Hassabis, ata të Anthropic Dario etj. Kjo lëvizje, ka prodhuar disa punë të rëndësishme shkencore, por shpesh i afrohet pozicioneve më ekstreme të tekno-apokaliptikëve.

Tekno-utopistët

Udhëheqësi i rrymës me optimiste në gjirin e ekspertëve në lidhje me zhvillimin e Inteligjencës Artificiale është padyshim investitori shumë i fuqishëm Marc Andreessen, themeluesi i kompanisë A16Z, dhe autor i një eseje të botuar kohët e fundit me titull “Inteligjenca Artificiale do të shpëtojë botën”.

Natyrisht, edhe në këtë grup, vëmendje i kushtohet rreziqeve të mundshme që vijnë nga Inteligjenca Artificiale. Dhe nuk ka asnjë dyshim, që edhe këta janë dakord me parashikimin se një Inteligjencë Artificiale shumë e fuqishme mund të lindë brenda pak vitesh. Ajo që i dallon nga të tjerët, është besimi që nëse zhvillohet në mënyrën e duhur, një teknologji do ta çojë botën drejt një utopie të re socio-ekonomike.

Ky është një vizion i përshkruar gjerësisht në esenë e fundit me titull “AI 2041” nga shkencëtari kompjuterik dhe investitori Kai-Fu Lee, ku përmes një historie fantastiko-shkencore, ai përshkruan se si Inteligjenca Artificiale do të krijojë një “ekonomi të bollëkut”, që do të na çlirojë nga çdo lloj vështirësie ekonomike, do të na lejojë ta zgjasim pa masë jetëgjatësinë, do të na çlirojë nga zgjedha e punës, por jo vetëm.

Për këtë arsye, utopistët janë kundër çdo rregullimi që mund të ngadalësojë zhvillimin e AI. Ata synojnë të arrijnë sa më shpejt tek një AI e plotfuqishme. Përveç Andresseen dhe Sam Altman, figura të tilla si kreu ekzekutiv i Microsoft Satya Nadella apo Google Sundar Pichai, përfshihen shpeshherë në grupin e utopistëve. Por a jemi vërtet të sigurt se vizioni i tyre është një vizion i vërtetë i së ardhmes, dhe se ata nuk janë thjesht të interesuar të maksimizojnë kthimin e investimeve të tyre në këtë sektor?

Eticienët e Inteligjencës Artificiale

Grupet që kemi përmendur deri më tani janë të shqetësuar për të ardhmen, mbi shfaqjen e një super-inteligjence, se si ta shmangnim atë, si ta menaxhojmë më mirë apo të shfrytëzojmë sa më shumë potencialin e saj. Të gjitha këto grupime, ndajnë gjithashtu një interpretim shumë ideologjik dhe fantastiko-shkencor.

Ndërkohë grupi i katërt ka padyshim shqetësime më konkrete, realiste dhe të menjëhershme.

Ata janë ekspertët e etikës së Inteligjencës Artificiale, që në vend se të merren me apokalipse apo utopi, përpiqen të tërheqin vëmendjen ndaj rreziqeve aktuale që paraqet kjo teknologji.

Why do ChatGPT or Midjourney tend to produce stereotypical and discriminatory images of society, and what are the dangers of a technology that tends to perpetuate the status quo, rather than help us overcome it?

What are the dangers of a purely statistical tool, used in very sensitive areas such as surveillance, health care, job selection, etc.? To this group – mostly from universities – we owe the discovery of how (and why) the Amazon algorithm used for personnel selection systematically discriminated against women, how facial recognition systems used by US police are deeply flawed, more often when it comes to identifying women or people belonging to ethnic minorities, etc.

The best-known exponent is researcher Timnit Gebru, author of a 2020 study on the risks of discrimination inherent in systems like ChatGPT (the study that led to her firing from Google, where she headed the ethics committee). So is Joy Buolamwini (founder of the Algorithmic justice league), Kate Crawford (author of the essay "Neither artificial nor intelligent"), and University of Washington linguist Emily Bender

Coming primarily from the academic world, and inevitably endowed with much lower economic resources and media power than Musk, Altman et al., Timnit Gebru and other researchers are managing to at least partially counter the futuristic visions of other groups. . Thanks to them, the European AI Act focuses above all on concrete risks. His American counterpart does the same.

One can only hope that their influence will continue to grow. And the media also have their responsibility for this.

Happening now...

83 mandates are not immunity for Rama's friends

ideas

top

Alfa recipes

TRENDING

services

- POLICE129

- STREET POLICE126

- AMBULANCE112

- FIREFIGHTER128